모든 정보와 슬라이드는 "MIT 6.S191 (2023): Deep Generative Modeling"을 참고했다.

GANs (Generative Adversarial Networks)

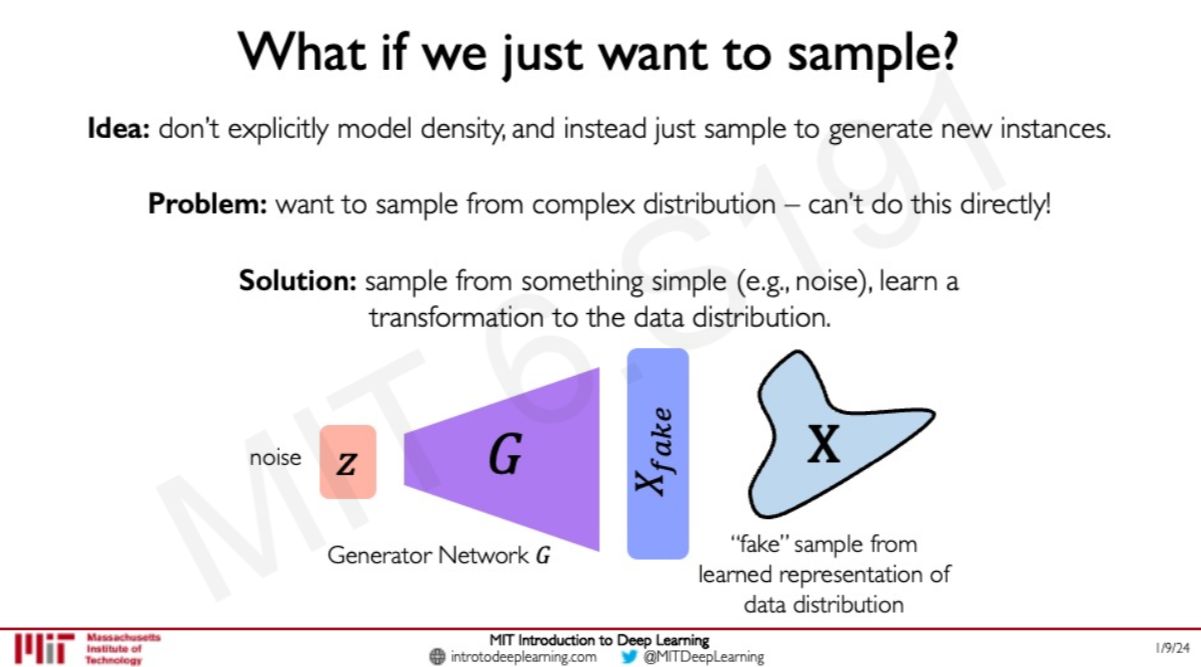

only care the quailty of the sample? What if we just want to sample?

▶️Generator Network를 train해서 noise에서 training data distribution으로 transform하게 하는 것

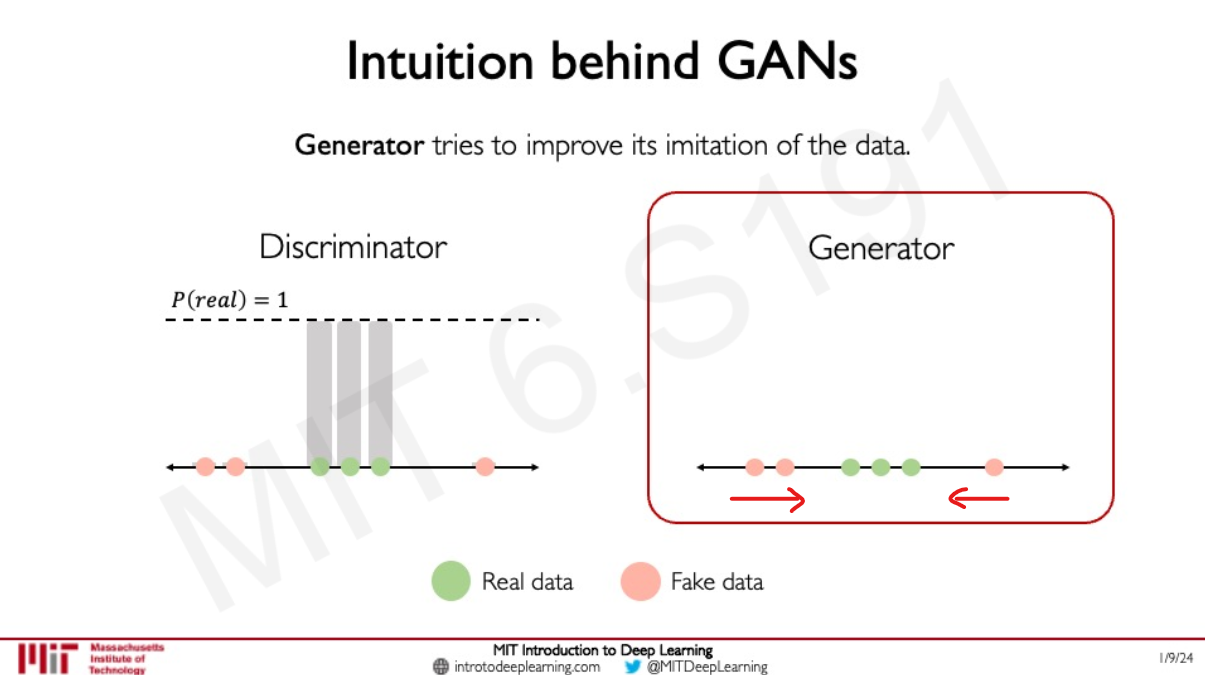

두개의 Neural Network를 통해 서로 경쟁하며 더 좋은 model을 만들도록 하는 것

➡️하나는 진짜 같은 가짜를 만들고, 하나는 진짜를 판별하고

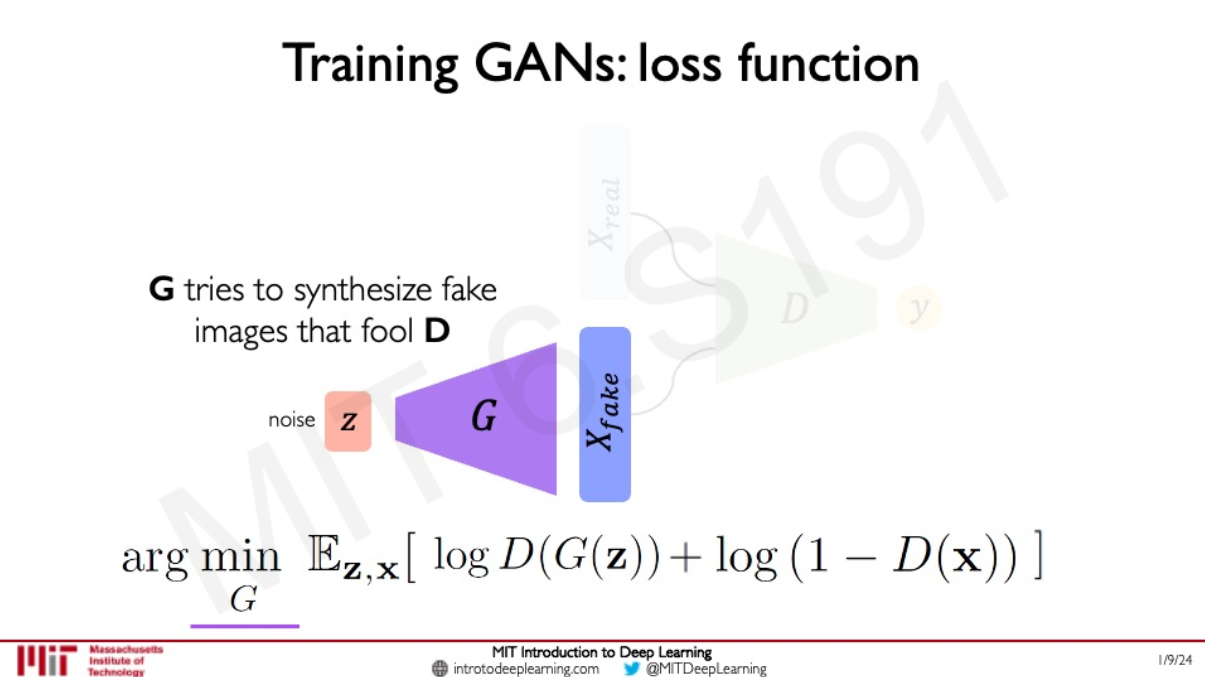

$$arg\,\underset{G}{min}\,\underset{D}{max}\,\mathbb{E}_{z, x}[ \, logD(G(Z)) + log(1-D(x)) \, ] $$

여기에서 D(x)는 Distriminator 가 가짜라고 판명할 확률이여서 1 - D(x)가 진짜일 확률이다.

Conditional GANs

Generator 와 Distriminator에 각각 condition 추가

ex) 위성 사진 ↔️ 지도의 평면 사진 변환 기능

Cycle GANs

다른 GANs들은 noise 에서 target data manifold로 갔다면 CycleGAN은 data manifold X 에서 data manifold Y

ex) transforming speech (voice를 바꾸는 것 가능)

© Alexander Amini and Ava Amini

MIT Introduction to Deep Learning

IntroToDeepLearning.com

'딥러닝' 카테고리의 다른 글

| Language Deep Learning 찍먹 (2) | 2024.06.13 |

|---|---|

| MIT 6.S191 (2023): Convolutional Neural Networks (2) | 2024.06.07 |

| MIT 6.S191 (2023): Recurrent Neural Networks, Transformers, and Attention (44:50~) (0) | 2024.06.07 |

| MIT 6.S191 (2023): Recurrent Neural Networks, Transformers, and Attention (~44:50 RNN, LSTM) (0) | 2024.06.06 |

| MIT 6.S191 (2023): Deep Generative Modeling (~41:25 VAE) (1) | 2024.06.06 |